Im Inneren eines KI-Gehirns: Die verborgene Schönheit von neuronalen Netzwerken mit DeepSeek R1 und Llama-Modellen

Im Gehirn einer KI

Wenn wir mit KI-Sprachmodellen wie ChatGPT, Llama oder DeepSeek interagieren, beschäftigen wir uns mit Systemen, die Milliarden von Parametern enthalten - aber was bedeutet das eigentlich? Heute werden wir uns eingehend mit der Struktur dieser riesigen neuronalen Netzwerke beschäftigen und faszinierende Möglichkeiten zur Visualisierung ihrer inneren Abläufe erkunden.

In ihrem Kern sind Sprachmodelle komplexe Netzwerke aus miteinander verbundenen künstlichen Neuronen. Jede Verbindung zwischen diesen Neuronen hat ein Gewicht, das wir als Parameter bezeichnen. Diese Gewichte bestimmen, wie Informationen durch das Netzwerk fließen und letztendlich die Ausgaben des Modells beeinflussen. Wenn wir sagen, dass ein Modell wie Llama-3 70 Milliarden Parameter hat, sprechen wir von 70 Milliarden einzelnen Zahlen, die zusammenarbeiten, um Text zu verarbeiten und zu generieren.

Diese Parameter sind keine zufälligen Zahlen - sie werden sorgfältig durch Training abgestimmt, um Muster in der Sprache zu erkennen. Man kann sie sich als winzige Knöpfe vorstellen, die das Modell beim Lernen anpasst, wobei jeder einzelne zu seinem Verständnis von Sprache, Kontext und Bedeutung beiträgt. Diese Parameter werden in Tensor-Dateien gespeichert.

Die Milliarden von Parametern in Sprachmodellen werden in spezialisierten Dateien namens Tensor-Dateien gespeichert (typischerweise mit der .safetensors-Erweiterung). Diese Dateien organisieren die Parameter in mehrdimensionalen Arrays, ähnlich wie Tabellenkalkulationen Daten in Zeilen und Spalten organisieren, aber mit der Möglichkeit, sich in mehrere Dimensionen zu erstrecken. Während die Rolle jedes Arrays für dieses kurze Experiment, das wir durchführen, nicht relevant ist, ist es wichtig zu bemerken, dass jede Menge von Arrays (innerhalb der Tensor-Dateien) eine spezifische Funktion in der Architektur des LLM hat.

Diese Dateien werden wir versuchen zu visualisieren. Typische Visualisierungstechniken für neuronale Netzwerke sind: Liniendiagramme, Histogramme, Netzwerkdiagramme, 3D-Oberflächendiagramme und Heatmaps. Aus diesen Optionen haben wir uns für das aktuelle Übung für Heatmaps entschieden.

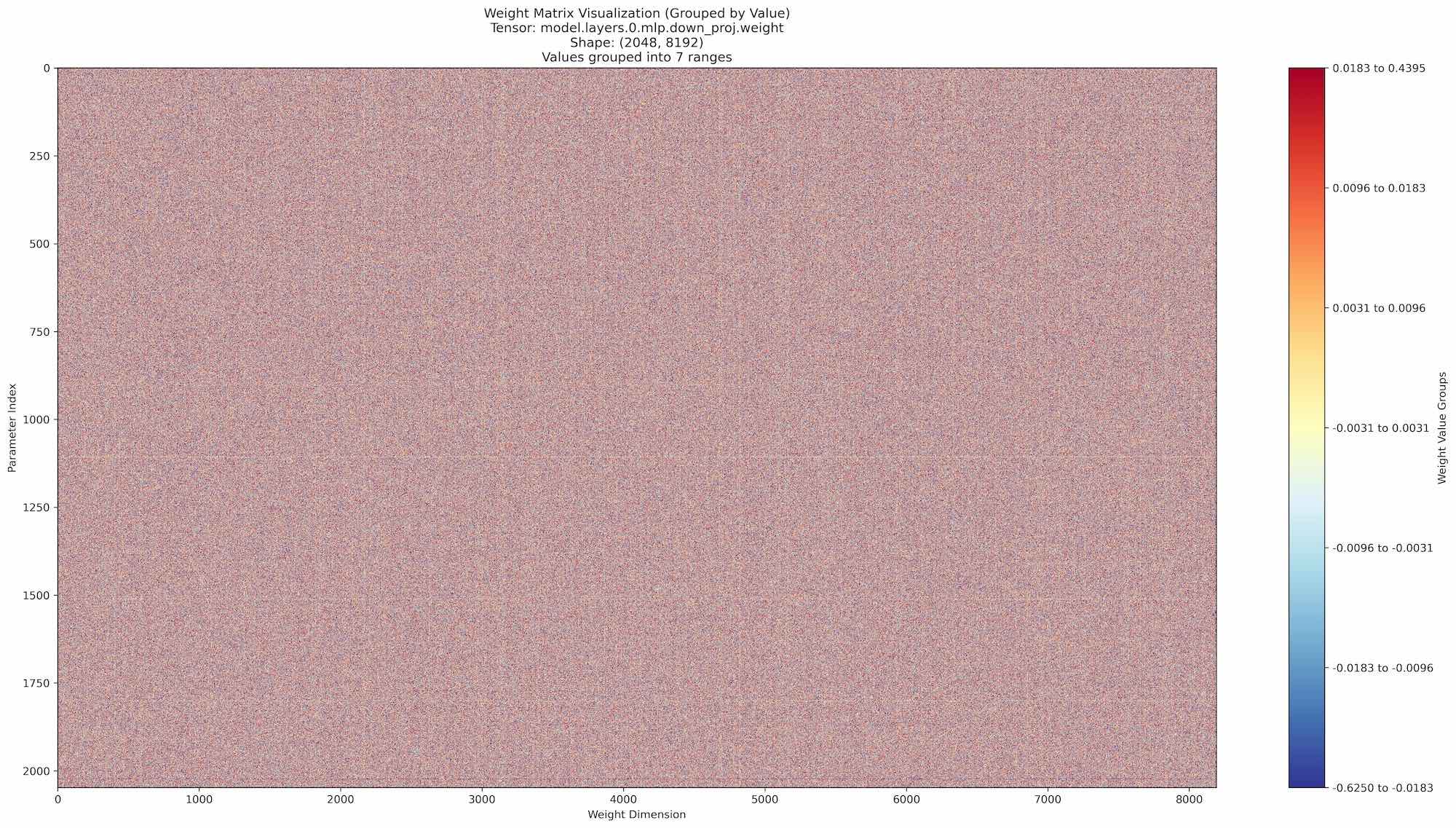

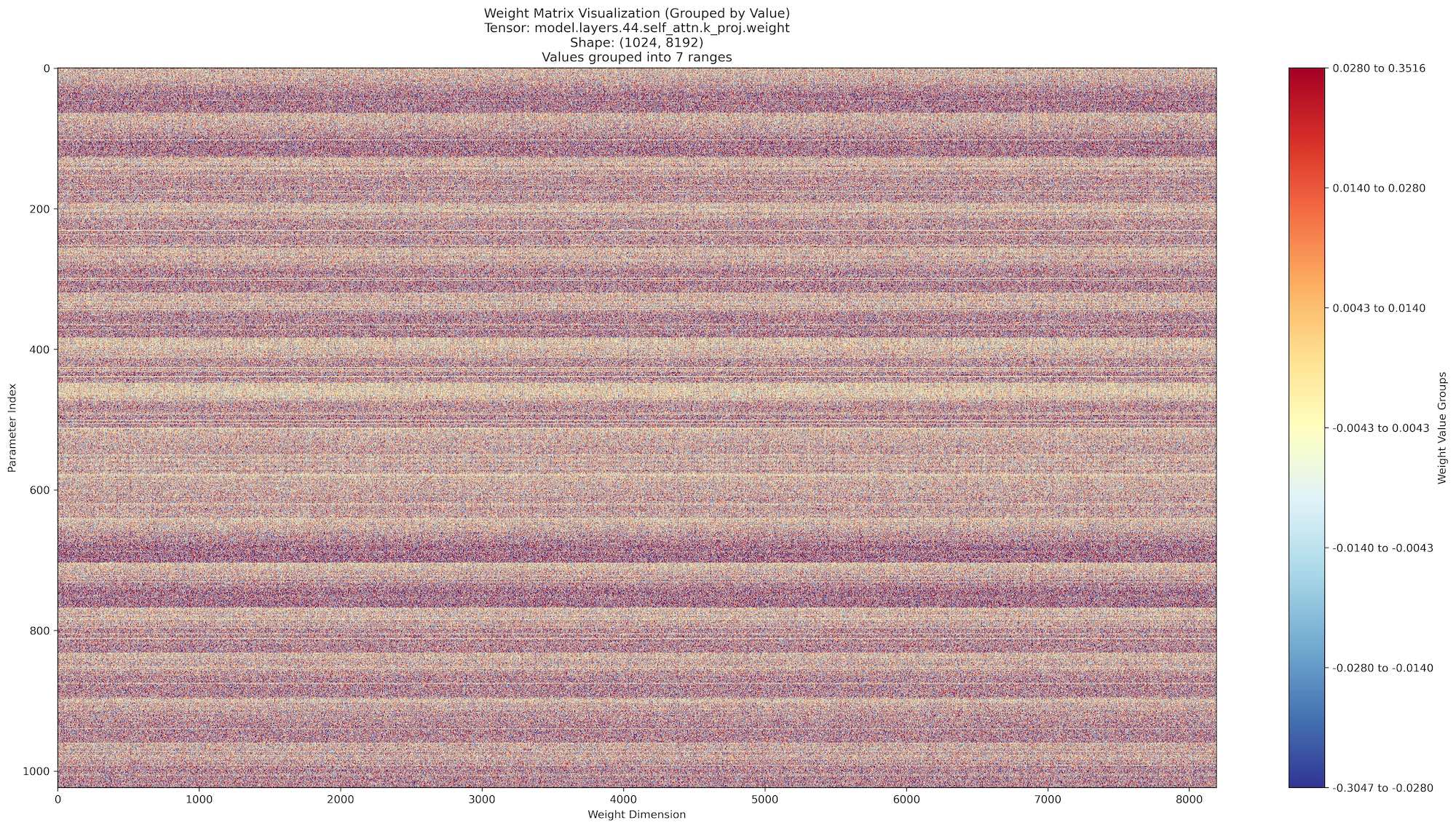

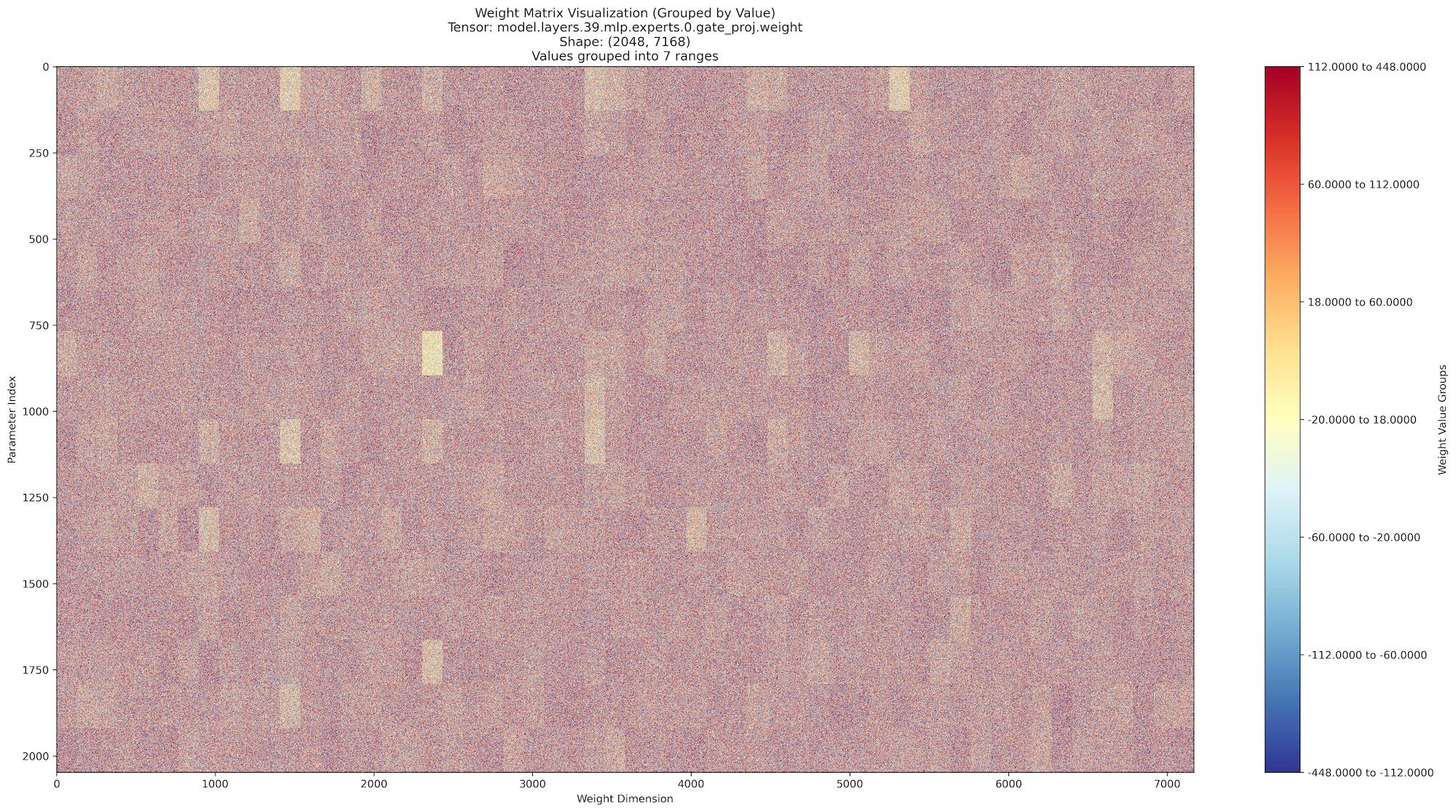

Die Heatmap-Visualisierung verwendet speziell diese Matrixstruktur, um Gewichtsmuster zu zeigen, wobei:

- Jede Zeile einen Parameter darstellt

- Jede Spalte eine Dimension darstellt

- Die Werte in den Zellen die tatsächlichen Gewichte sind

Beginnen wir mit unserem ersten Modell für die Analyse: Llama 3.2 - 3B Parameter. Zunächst können wir hauptsächlich ein "Rausch"-Muster erkennen, ohne dass sich deutliche Muster abzeichnen.

Lassen Sie uns ein Modell mit etwas höheren Parametern, Llama 3.3 - 70B, untersuchen. Während das Rauschmuster bestehen bleibt, können wir einige subtile Muster in Form von vertikalen und horizontalen Linien beobachten. Diese Muster sind visuell faszinierend, aber sie sind noch nicht aussagekräftig genug für eine bedeutungsvolle Analyse.

Die letzte Analyse konzentriert sich auf das größte zum Zeitpunkt der Verfassung dieses Blogbeitrags verfügbare Open-Source-Modell: DeepSeek - R1 (Version 3). In dieser Phase werden die Visualisierungen deutlich interessanter. Wir beobachten ausgeprägte rechteckige Muster, die in den Visualisierungen der Tensor-Dateien auftauchen und auf eine strukturiertere Organisation der Modellparameter hindeuten.

Diese rechteckigen Formationen werfen eine interessante Frage auf: Könnten sie auf eine Art "messbare" visuelle Intelligenz in diesen Modellen hinweisen?

Obwohl es verlockend ist, Schlussfolgerungen zu ziehen, sollten wir bei unserer Interpretation vorsichtig bleiben. Ohne Zugang zu Modellen mit noch höheren Parameterzahlen zum Vergleich, ist es verfrüht, endgültige Aussagen darüber zu treffen, was diese Muster bedeuten. Dennoch bieten diese Beobachtungen einen spannenden Abschluss unserer experimentellen Erkundung.

Wenn Sie daran interessiert sind, diese Visualisierungen in Aktion zu sehen, hat unser CEO ein kurzes Video-Tutorial zu dieser Analyse erstellt, das Sie hier finden können.

Bereit, Ihr Geschäft mit maßgeschneiderten KI-Lösungen zu transformieren?

Bei Softescu sind wir darauf spezialisiert, intelligente KI-Anwendungen zu entwickeln, die Ihre einzigartigen Geschäftsanforderungen verstehen. Unser Team aus KI-Ingenieuren und Experten für maschinelles Lernen kann Ihnen helfen, die Kraft von Large Language Models und konversationeller KI zu nutzen und gleichzeitig eine nahtlose Integration in Ihre bestehenden Systeme zu gewährleisten. Ob Sie Prozesse automatisieren, Kundenerlebnisse verbessern oder tiefere Geschäftseinblicke gewinnen möchten, kontaktieren Sie uns für eine individuelle KI-Lösungsberatung.